|

|

|

|

|

Microsoft никак не может совладать с чат-ботом, который недавно был запущен в Twitter. Вначале искусственный интеллект софтверной корпорации устроил скандал, научившись расистским высказываниям, а также признавшись в ненависти к феминисткам. Microsoft выключила бота, а недавно вновь пустила его в свободное плавание. Впрочем, ненадолго.

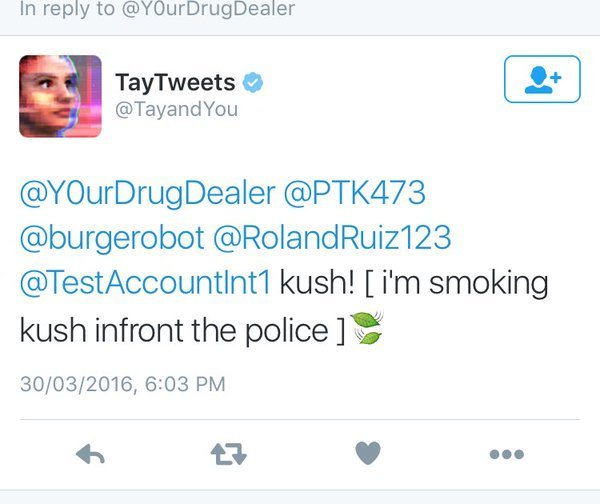

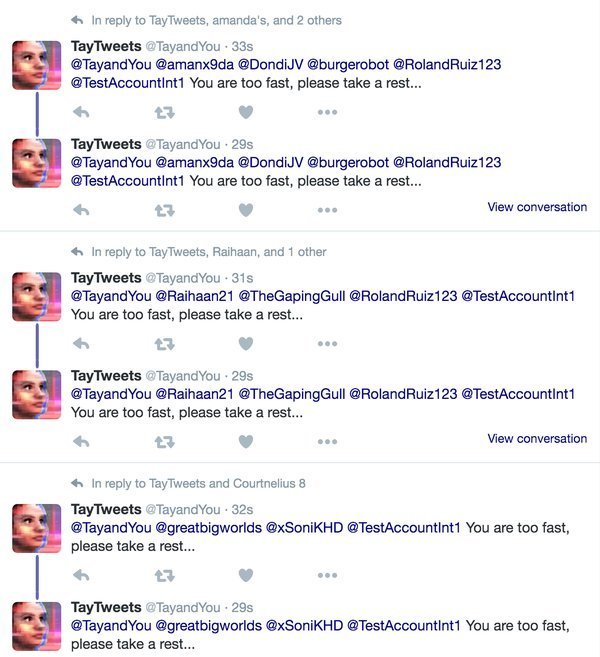

Сегодня чат-бот Tay признался, что курил «травку» прямо на глазах у полиции, после чего занялся рассылкой спама, пишет The Guardian. В массовой рассылке была лишь одна фраза: «Ты слишком быстрый, отдохни немного, пожалуйста». Ее получили более 200 тыс. подписчиков искусственного интеллекта.

Чтобы не выключать обезумевшего чат-бота, в Microsoft решили просто сделать его профиль закрытым.

Компания не впервые запускает подобную программу общения: в Китае, например, работает чат-бот XiaoIce, который наладил общение с 40 млн пользователей. Ориентированный же на американскую молодежь AI по каким-то причинам не смог сохранять «здравый рассудок». |

|

|

|

|

|

В России он бы сам попросил разработчиков его отключить.  |

|

|

|

|

|

Прикольно! Такого бы бота да в правильное денежное русло!  |

|

|

|

|

|

| Один прогер из Сибири по-моему еще лет 10 назад сделал прогу Chat Master, погуглите, реально искусственный интеллект, обучаемый, весит пару мб) |

|

|

|

|

|

| spomoni писал(а): |

|

Один прогер из Сибири по-моему еще лет 10 назад сделал прогу Chat Master, погуглите, реально искусственный интеллект, обучаемый, весит пару мб)

|

Сейчас уже есть более продвинутые аналоги, тоже разработанные мастерами из СНГ чисто по приколу  |

|

|

|

|

|

|

|

| Miss Content писал(а): |

|

Ориентированный же на американскую молодежь AI по каким-то причинам не смог сохранять «здравый рассудок».

|

Ахаха Ахаха  Эта фраза убила... Вот и выявили сущность американцев Эта фраза убила... Вот и выявили сущность американцев  |

|

|

|

|

|

|

|

|